在DeepSeek開源周的精彩延續中,摩爾線程于近日宣布了一項重大進展——成功集成并開源了針對DeepSeek通信庫DeepEP與并行算法DualPipe的支持。這一成果標志著摩爾線程在推動大模型訓練與推理效率方面邁出了堅實的一步,相關開源代碼倉庫MT-DeepEP與MT-DualPipe也隨之亮相。

DeepEP,這一專為混合專家(MoE)模型設計的開源通信庫,通過優化通信信道的使用,顯著提升了大模型訓練的效率,特別是在集群訓練中展現出卓越性能。摩爾線程憑借MUSA Compute Capability 3.1全功能GPU的強大實力,成功適配了DeepEP,并引入了一系列創新特性,包括高效優化的All-to-All通信機制、MTLink + GPU節點內通信支持、高吞吐量與低延遲計算核心的靈活切換、原生FP8數據分發能力,以及GPU資源的靈活調度,實現了計算與通信的高效協同。

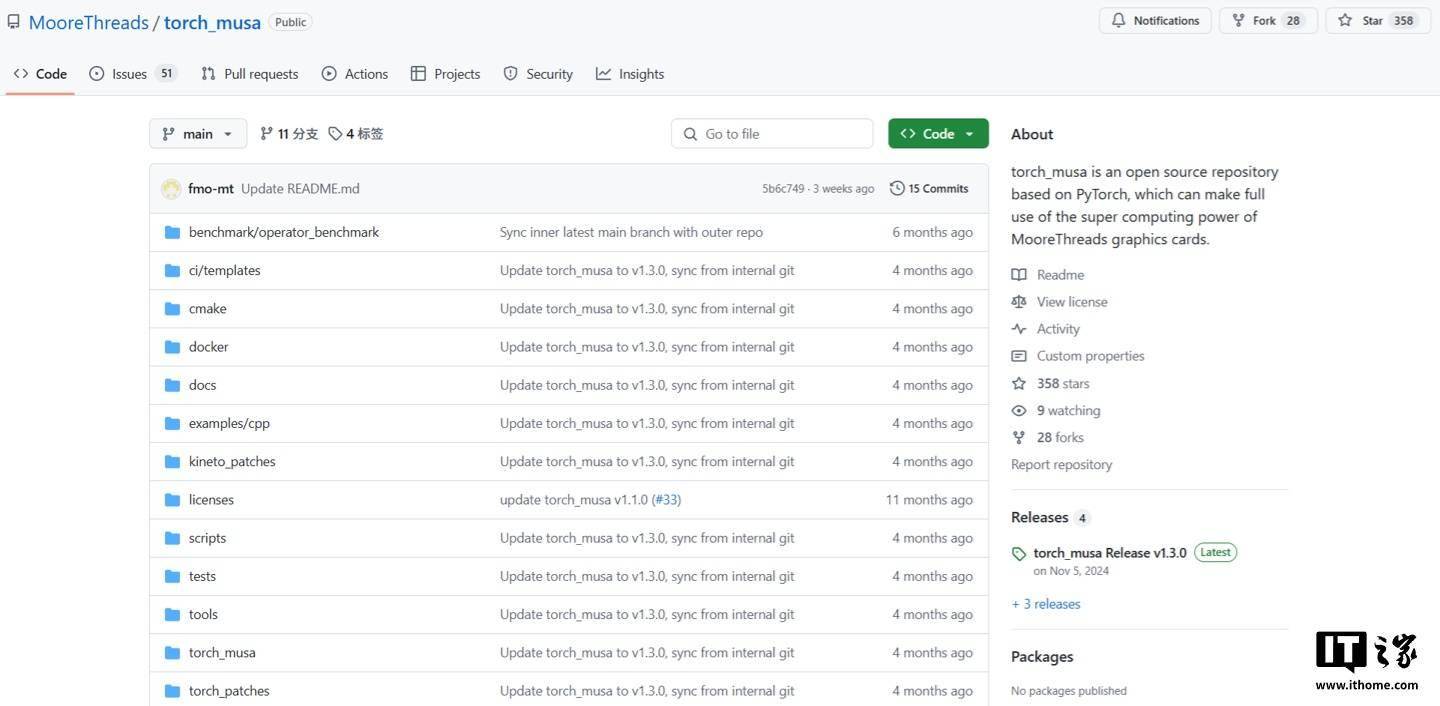

另一方面,DualPipe作為DeepSeek-V3的核心算法,通過實現前向與后向計算階段計算與通信的完全重疊,有效減少了“流水線氣泡”,即設備空閑等待時間,從而進一步提升了訓練效率。摩爾線程依托其深度學習框架Torch-MUSA(已開源)及MUSA軟件棧的全面兼容性,成功實現了對DualPipe算法的支持。目前,MT-DualPipe已無縫接入摩爾線程的MT-Megatron與MT-TransformerEngine框架(后者即將開源),能夠完整復現DeepSeek V3的訓練流程。

值得注意的是,MT-DualPipe與MT-Megatron的結合,不僅實現了DeepSeek V3模型中MLP-FFN與DW-DG的分離,進一步降低了氣泡占比,還優化了通信效率。同時,MT-DualPipe與MT-TransformerEngine及MT-DeepEP的協同工作,借助MT-DeepEP的異步通信引擎,實現了更高效的通信掩蓋,有效降低了對計算資源的損耗。這一系列創新技術的融合,無疑為摩爾線程在大模型訓練與推理領域的發展注入了強勁動力。

對于有志于探索大模型訓練與推理技術的開發者而言,摩爾線程的開源成果無疑提供了一套強大的工具集。Torch-MUSA開源地址的公布,更是為開發者們打開了一扇通往高效深度學習實踐的大門。