近日,AI大模型DeepSeek-R1的使用難題成為了用戶們關(guān)注的焦點(diǎn)。此前,用戶主要通過云服務(wù)或本地部署來使用這款模型,但云服務(wù)頻繁宕機(jī),而本地部署的版本多為參數(shù)量大幅縮水的蒸餾版。對(duì)于一般用戶而言,在普通硬件上運(yùn)行DeepSeek-R1的滿血版幾乎是不可能的任務(wù),即便是開發(fā)者,租賃服務(wù)器的成本也令人望而卻步。

然而,這一局面即將迎來重大改變。清華大學(xué)KVCache.AI團(tuán)隊(duì)與趨境科技攜手發(fā)布的KTransformers開源項(xiàng)目,近日宣布取得了突破性進(jìn)展,成功破解了千億級(jí)大模型本地部署的難題。這一突破標(biāo)志著大模型推理將擺脫“云端壟斷”,走向更加普惠化的道路。

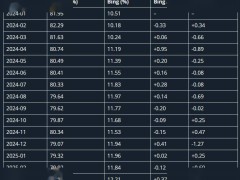

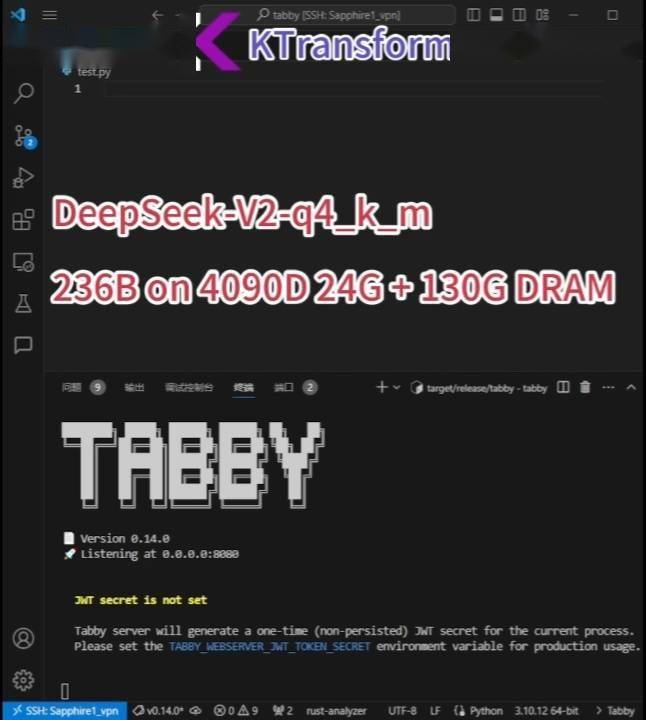

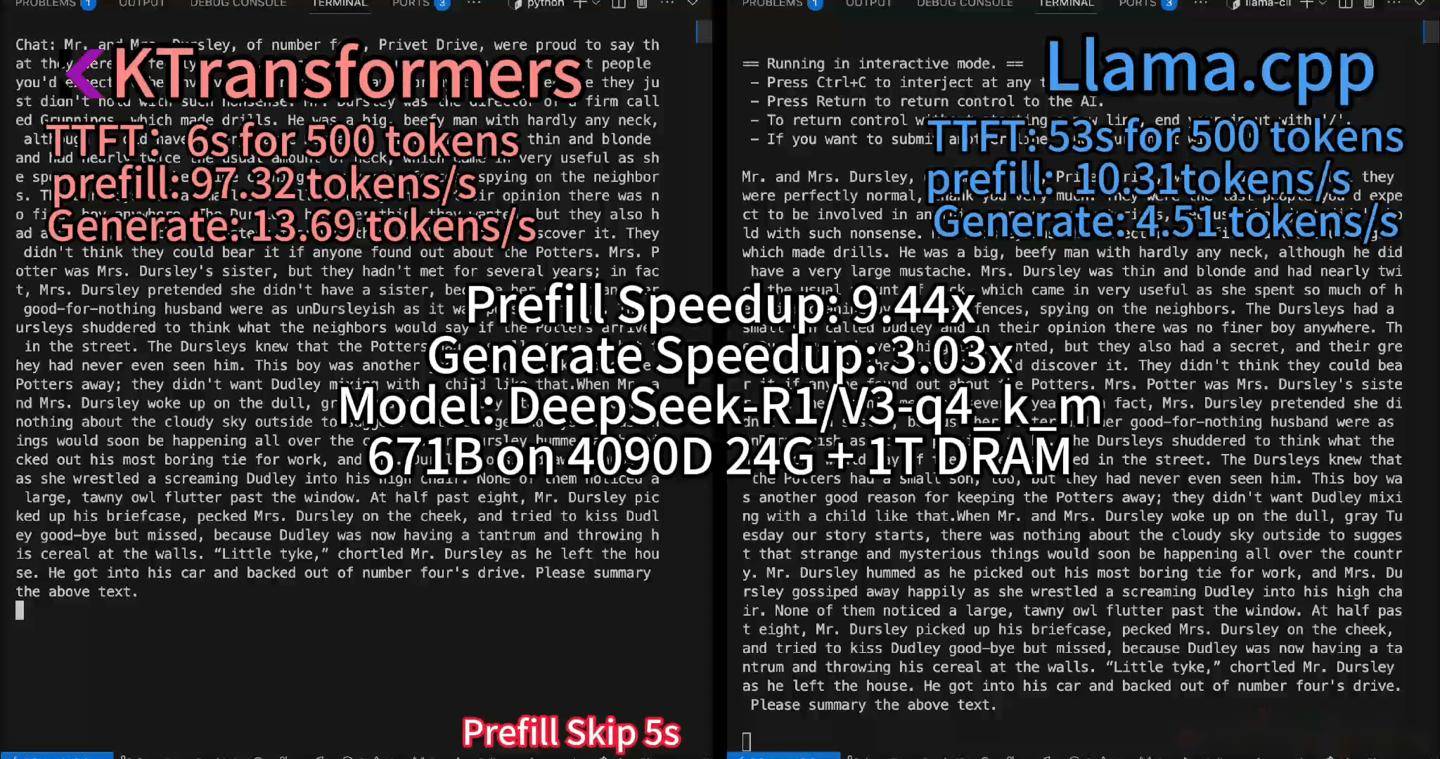

據(jù)KTransformers團(tuán)隊(duì)介紹,他們已在配備24GB顯存和382GB內(nèi)存的PC上成功實(shí)現(xiàn)了DeepSeek-R1、V3的671B滿血版的本地運(yùn)行,速度提高了3至28倍。不僅如此,他們還宣布支持更長的上下文(24GB單卡支持4~8K),并實(shí)現(xiàn)了15%的加速,每秒最多可處理16個(gè)Tokens。

KTransformers作為一個(gè)以Python為中心的靈活框架,其核心設(shè)計(jì)注重可擴(kuò)展性。用戶只需通過一行代碼即可實(shí)現(xiàn)和注入優(yōu)化模塊,從而訪問兼容Transformers的界面、符合OpenAI和Ollama標(biāo)準(zhǔn)的RESTful API,甚至是類似ChatGPT的簡(jiǎn)化網(wǎng)頁用戶界面。這一技術(shù)的推出,徹底改寫了AI大模型依賴昂貴云服務(wù)器的歷史格局。

DeepSeek-R1基于混合專家(MoE)架構(gòu),通過將任務(wù)分配給不同專家模塊,并在每次推理時(shí)僅激活部分參數(shù)來提高效率。KTransformers團(tuán)隊(duì)創(chuàng)新性地將非共享稀疏矩陣卸載至CPU內(nèi)存處理,并結(jié)合高速算子優(yōu)化,成功將顯存需求從傳統(tǒng)8卡A100的320GB壓縮至單卡24GB。這一創(chuàng)新使得普通用戶只需24G顯存即可在本地運(yùn)行DeepSeek-R1、V3的671B滿血版,預(yù)處理速度最高可達(dá)286 tokens/s,推理生成速度最高能達(dá)到14 tokens/s。

KTransformers團(tuán)隊(duì)還通過減少CPU/GPU通信斷點(diǎn),實(shí)現(xiàn)單次解碼僅需一次完整的CUDA Graph調(diào)用,生成速度優(yōu)化至14 tokens/s,功耗僅為80W,整機(jī)成本約2萬元,僅為傳統(tǒng)8卡A100方案的2%。經(jīng)過開發(fā)者實(shí)測(cè),使用RTX 3090顯卡和200GB內(nèi)存配置,結(jié)合Unsloth優(yōu)化,Q2_K_XL模型推理速度可達(dá)9.1 tokens/s,實(shí)現(xiàn)了千億級(jí)模型的“家庭化”運(yùn)行。

值得注意的是,KTransformers并非一個(gè)單純的推理框架,也不限于DeepSeek模型。它可以兼容各式各樣的MoE模型和算子,能夠集成各種算子并進(jìn)行各種組合的測(cè)試。同時(shí),KTransformers還提供了Windows、Linux平臺(tái)的支持,感興趣的用戶可自行嘗試。但要想使用KTransformers,也需要滿足一定的硬件條件,包括英特爾至強(qiáng)Gold 6454S 1T DRAM CPU、RTX 4090D(24G VRAM)GPU、標(biāo)準(zhǔn)DDR5-4800服務(wù)器DRAM(1TB)內(nèi)存以及CUDA 12.1或更高版本。