昨日,深度求索公司宣布其DeepSeek R1模型已完成最新的小版本迭代,新版本被命名為DeepSeek-R1-0528。用戶現(xiàn)在可以通過官方網(wǎng)站、App以及小程序進入對話界面,并啟用“深度思考”功能,來體驗這一最新版本。同時,API接口也已同步更新,且調(diào)用方式維持原樣。

深度求索公司在晚間詳細公布了此次DeepSeek-R1-0528版本的更新內(nèi)容。據(jù)悉,該版本依舊基于2024年12月發(fā)布的DeepSeek V3 Base模型,但后訓練過程中投入了更多的算力,顯著提升了模型的思維深度和推理能力。在多個基準測評中,包括數(shù)學、編程和通用邏輯等方面,DeepSeek-R1-0528取得了國內(nèi)領先的成績,并且在整體表現(xiàn)上已接近國際頂尖模型,如o3和Gemini-2.5-Pro。

在各項評測集上,DeepSeek-R1-0528均展現(xiàn)出卓越表現(xiàn)。特別是在AIME 2025測試中,新模型的準確率從舊版的70%提升到了87.5%。這一顯著進步得益于模型在推理過程中思維深度的增強。在AIME 2025測試集上,舊版模型平均每題使用12K tokens,而新版模型則提升至23K tokens,顯示出更為詳盡和深入的解題思考。

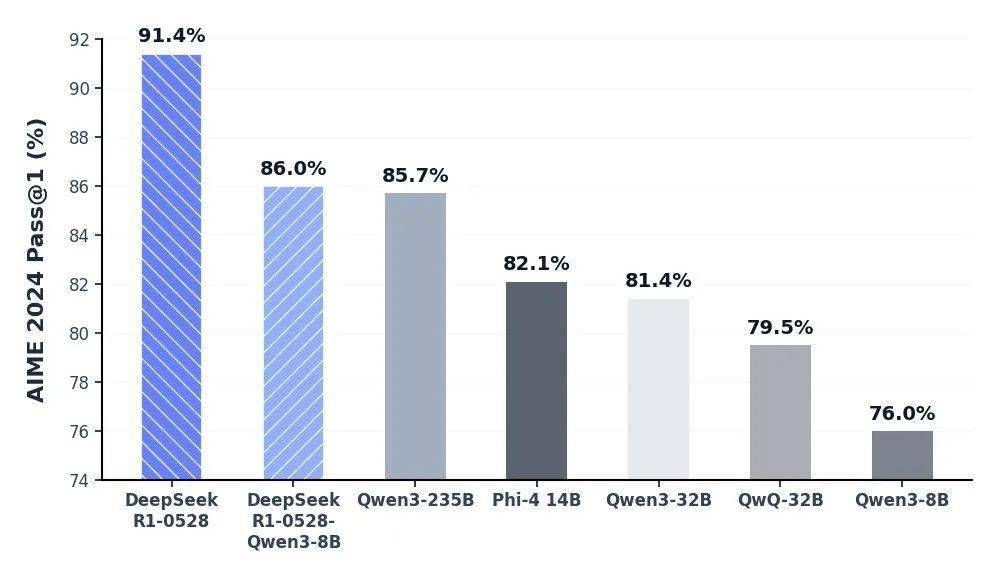

官方還利用DeepSeek-R1-0528的思維鏈對Qwen3-8B Base進行了蒸餾,得到了DeepSeek-R1-0528-Qwen3-8B。在數(shù)學測試AIME 2024中,該8B模型的表現(xiàn)僅次于DeepSeek-R1-0528,超越了Qwen3-8B(+10.0%),與Qwen3-235B相當。深度求索公司認為,DeepSeek-R1-0528的思維鏈將對學術界推理模型的研究以及工業(yè)界小模型的開發(fā)產(chǎn)生重要影響。

除了深度思考能力的增強,DeepSeek-R1-0528還在其他方面進行了優(yōu)化。針對“幻覺”問題,新版模型在改寫潤色、總結(jié)摘要、閱讀理解等場景中,幻覺率降低了45%至50%左右,提供了更為準確和可靠的結(jié)果。在創(chuàng)意寫作方面,新版R1模型針對議論文、小說、散文等文體進行了優(yōu)化,能夠輸出篇幅更長、結(jié)構內(nèi)容更完整的長篇作品,并且寫作風格更加貼近人類偏好。

在工具調(diào)用方面,DeepSeek-R1-0528也進行了支持,不過目前還不支持在“思考”功能中進行工具調(diào)用。當前,該模型在Tau-Bench測評中的成績?yōu)閍irline 53.5% / retail 63.9%,與OpenAI的o1-high相當,但與o3-High以及Claude 4 Sonnet仍有一定差距。

DeepSeek-R1-0528還在前端代碼生成、角色扮演等領域的能力上進行了更新和提升。用戶現(xiàn)在可以在網(wǎng)頁端調(diào)用該模型,使用HTML/CSS/Java開發(fā)各種應用。

API接口也同步進行了更新,調(diào)用方式保持不變。新版R1 API支持查看模型的思考過程,并增加了Function Calling和JsonOutput的支持。不過,官方對max_tokens參數(shù)的含義進行了調(diào)整,現(xiàn)在該參數(shù)用于限制模型單次輸出的總長度(包括思考過程),默認為32K,最大為64K。API用戶需及時調(diào)整該參數(shù),以防輸出被提前截斷。

此次更新后,官方網(wǎng)站、小程序、App端和API中的模型上下文長度仍為64K。若用戶對更長的上下文長度有需求,可以通過第三方平臺調(diào)用上下文長度為128K的開源版本R1-0528模型。

DeepSeek-R1-0528與之前的DeepSeek-R1使用同樣的base模型,僅改進了后訓練方法。私有化部署時,用戶只需更新checkpoint和tokenizer_config.json(tool calls相關變動)。該模型參數(shù)為685B(其中14B為MTP層),開源版本上下文長度為128K(網(wǎng)頁端、App和API提供64K上下文)。用戶可以在Huggingface等平臺下載DeepSeek-R1-0528的模型權重,此次開源倉庫(包括模型權重)仍然采用MIT License,并允許用戶利用模型輸出、通過模型蒸餾等方式訓練其他模型。